前天蓝点网提到MLC团队推出支持在手机上运行的AI模型 ,该团队还开发iOS版的演示程序可进行轻度体验。

恰逢假期蓝点网今晚才有空进行体验和测试,虽然看开发团队的说明我已经做好心理准备但着实还是自信了。

实际体验下来也确实只有演示功能不能正常使用,主要是手机内存和图形性能还是不够运行模型还是太吃力。

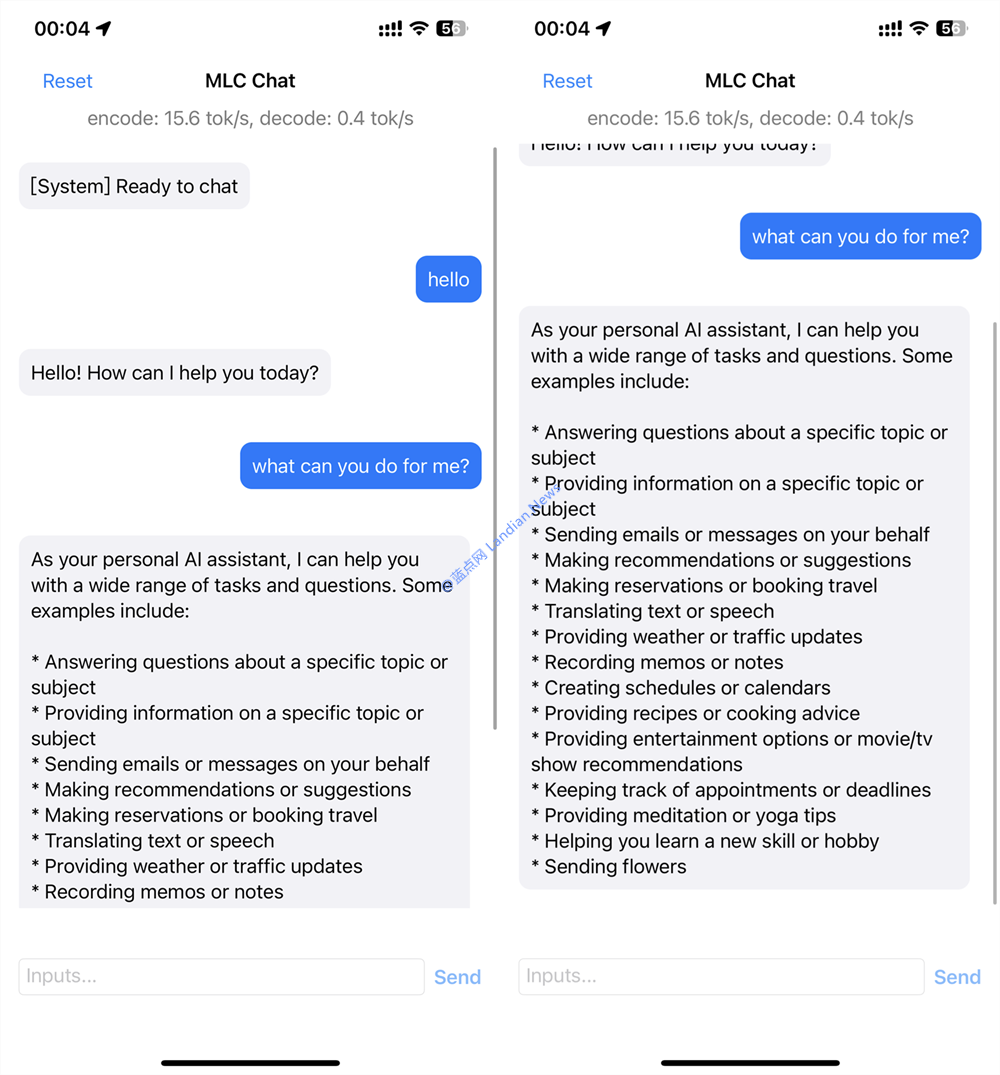

👆生成上面的回答大约花费20分钟

MLC Chat为何值得关注:

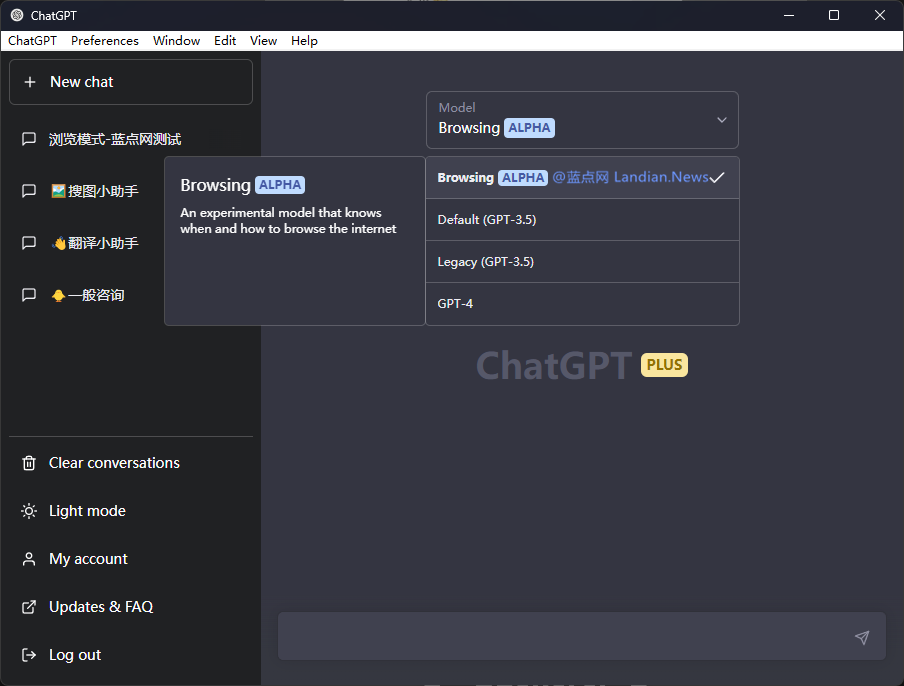

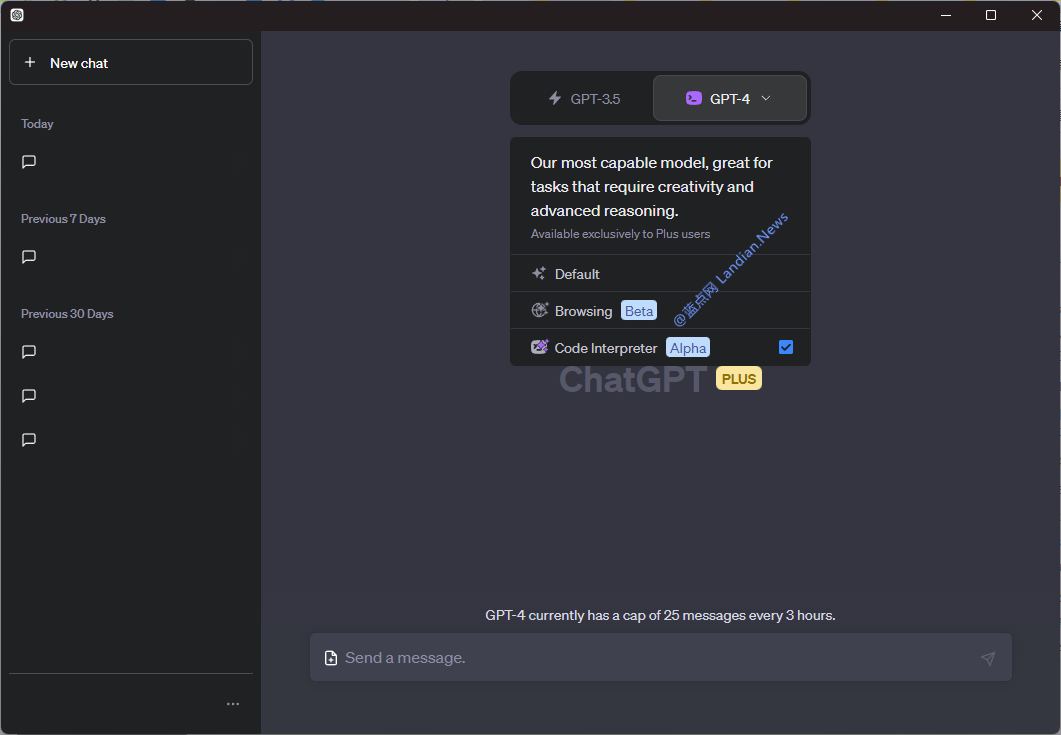

目前各位熟知的AI模型都是基于云端的,即模型在云端运行由服务提供商利用GPU阵列提供强大的算力支持。

使用这些人工智能机器人的缺点就是你的对话会被服务提供商收集,鬼知道下次提问是不是推荐莆田系医院。

也有不少开源模型支持离线部署,不过配置较低的显卡通常极其卡顿或直接无法使用,这个暂时没解决办法。

既然桌面端都无法很好的运行模型那手机更不可能 , 但 MLC Chat 就是个基于手机本机运行的大型语言模型。

乐观预计未来我们应该可以人手一个离线的对话机器人,直接在本机运行,不用担心对话数据被泄密的问题。

所以MLC团队的工作是令人期待的,只不过吧,就目前来说想要在手机上运行离线的大型语言模型着实困难。

👆中文回答基本20~30字后就是乱码内容

体验遇到哪些问题:

测试机型是 iPhone 12 Pro Max,内存为6GB刚刚达到MLC Chat的门槛,内存足够可以保证模型能跑起来。

至于真正的对话还考验手机的 GPU 能力,比如在iPhone 12 Pro Max 上对话是可以对话但是速度极其缓慢。

由于返回的内容实在太慢不小心手机黑屏,再打开对话已经被重置,显然内存爆表系统直接把内存清理干净。

而且每次启动这个模型后其他程序也全部会被杀掉 ,这个倒是不意外,毕竟内存已经被MLC Chat直接耗尽。

就实际对话方面MLC Chat 的能力还是比较弱的,英文还能正常回答,中文内容基本都是各种乱码没法查看。

不过毕竟只是演示程序而且还是在手机本地运行的实验,出现这些问题完全能理解,期待后面体验越来越好。

你可以点击这里下载MLC Chat,模型3GB请耐心等待下载:https://testflight.apple.com/join/57zd7oxa

你也可以在 Windows、Linux、macOS 以及浏览器上体验该模型,具体可查看蓝点网前天发布的这篇文章。

本文来源 蓝点网,由本站 收集整理,其版权均为 原网址 所有,文章内容系作者个人观点,不代表 本站 对观点赞同或支持。如需转载,请注明文章来源。