OPENAI 推出的 ChatGPT 以及其他模型背后依靠的都是显卡,这些模型训练和工作都需要强大的算力支持,所以没错,老黄又赢了。

前几年流行挖矿让老黄赚的盆满钵满,现在新热点是人工智能,老黄还是赢家,因为只要涉及人工智能和机器学习,显卡都是少不了的,而英伟达的计算卡则是主力。

市场分析公司称 OPENAI 训练 ChatGPT 大约需要 20,000 张显卡,随着商业部署和提供其他模型,OPENAI 大约需要 30,000 张显卡。

但游戏玩家请不要担心,OPENAI 不会购买 RTX 4090/4080 的,虽然这些显卡是目前游戏领域最强的显卡之一,但用来大规模训练模型还是不够。

OPENAI 使用的是英伟达 A100 加速卡 (安培),单张价格在 10,000~15,000 美元左右,30,000 张 A100 加速卡总价在 3 亿美元以上。

不过商业企业大规模采购,英伟达肯定会给优惠,所以实际价格应该会低于 3 亿美元吧。

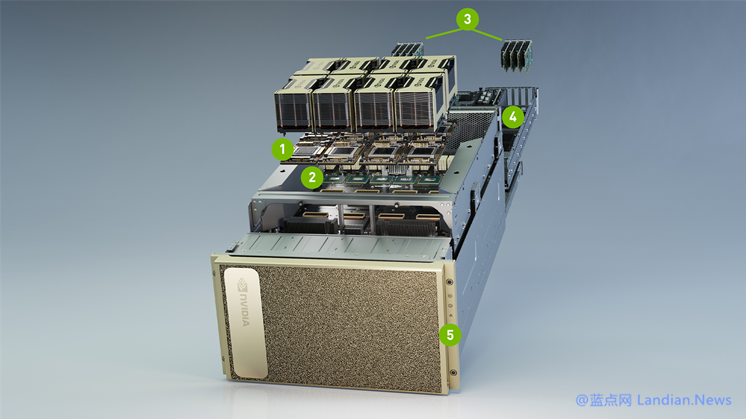

英伟达自己还搞了个 DGX A100 套装,名为人工智能基础架构通用系统,里面内置了 8 张 A100 加速卡,售价高达 19.9 万美元。

这个套装适合中小型规模的 AI 公司,但对于 OPENAI 来说,需要 2~3 万张 A100 加速卡,那肯定还是买卡划算,买 DGX A100 要被老黄割韭菜的。

值得注意的是英伟达也已经开始发售替代 A100 的新卡 — H100,代号哈勃,英伟达称 H100 的性能是 A100 的三倍,扩展性也更好,在 AI 训练中提供高达 9 倍的吞吐量。

“如此优秀” 那价格涨点不为过吧?所以老黄给 H100 的定价是 32,000 美元,是 A100 的三倍。

随着 AI 技术的火热,诸如微软等公司也要大规模采购英伟达的加速卡,而 AMD 和 Intel 也在提供 AI 加速卡试图抢占老黄的份额。

另外谷歌和亚马逊之类的顶级公司自己也在研究专门用于人工智能的芯片,所以整个市场的竞争还是很激烈的,只是当前老黄还是遥遥领先的。

本文来源 蓝点网,由本站 收集整理,其版权均为 原网址 所有,文章内容系作者个人观点,不代表 本站 对观点赞同或支持。如需转载,请注明文章来源。